駁“目錄的長度(深度)影響SEO優化效果”論

在全通公司工作也有兩年了,在這兩年里,有一個SEO優化問題是經常被客戶提及:網站后臺的目錄太深了,足足有四個文件夾,很不利于SEO優化的。面對這個問題時,小莫通常會選擇反問他們一句:為什么覺得這會影響SEO優化呢?他們對此的回答多半為:目錄深了,url就會變得很長,用戶體驗也就不好了,甚至會影響到權限和蜘蛛抓取。對此,小莫特意去搜索了相關的文章,的確也有這種說法的文章。但是,由于小莫從事網站建設行業多年,也曾做過搜索引擎相關的系統開發工作,對于蜘蛛原理也算是有一點了解。所以,今天就從技術層面來為大家分析一下,為什么小莫會覺得這些論調是錯誤的。

在反駁相關問題之前,我們還是先來了解一下網絡蜘蛛和網站權重的基本知識先吧。

一、網絡蜘蛛

網絡蜘蛛,別名網絡爬蟲,是一種按照一定的規則,自動地抓取萬維網信息的程序或者腳本。傳統的爬蟲會從宇哥或若干初始網頁的url開始,獲得初始網頁的url,在抓取網頁的時候,會不斷的從前一個頁面上抽取新的url放到隊列之中,直到滿足了系統的一定條件后,再對抓取到的頁面進行不同的分析和處理,以提高智能化的搜索結果排名。如果把整個互聯網當成一個網站,那么網絡蜘蛛就可以用這個原理把互聯網上所有的網頁都抓取下來。

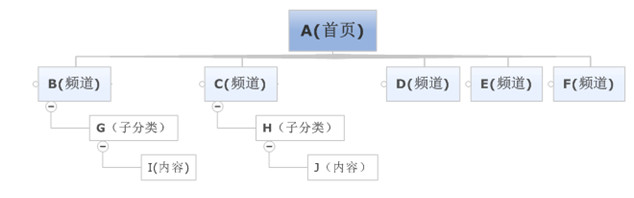

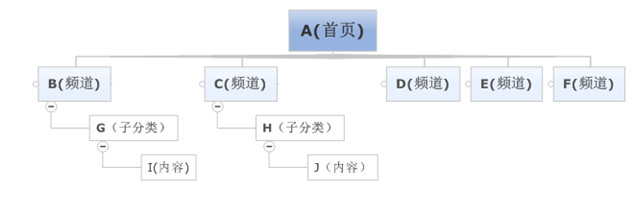

由于蜘蛛無法抓取互聯網上的所有網頁,所以會對一些不是那么重要的網站設置訪問層數。如,在圖1中,A為起始網頁,屬于0層,B、C、D、E、F屬于第1層,G、H屬于第2層,I、J屬于第3層。如果網絡蜘蛛設置的訪問層數為2的話,網頁I、J是不會被訪問到的。這也讓有些網站上一部分網頁能夠在搜索引擎上搜索到,另外一部分不能被搜索到。但按如圖2中,假如J的層級在A層級中出現,則J被視為和A一樣的同一級,也會被抓取。所以,對于網站設計者來說,扁平化的網站結構設計有助于搜索引擎抓取其更多的網頁。

圖一

圖二

網絡蜘蛛進入一個網站時,首先會去訪問一個特殊的文本文件,那就是Robots.txt。一般來說,這個文件會放在網站服務器的根目錄下,網站的管理員可以通過Robots.txt來定義那些目錄是網絡蜘蛛不能爬行的,或者是哪些目錄是哪些搜索引擎蜘蛛無法爬行的。例如有些網站的可執行文件目錄和臨時文件目錄不希望被搜索引擎搜索到,那么網站管理員就可以把這些目錄定義為拒絕訪問目錄。Robots.txt語法很簡單,例如如果對目錄沒有任何限制,可以用以下兩行來描述: User-agent: * Disallow:

當然,Robots.txt也只是一個協議而已,如果網絡蜘蛛的設計者不想遵守這個協議的話,網站管理員是無法阻止網絡蜘蛛對某些頁面的訪問的。但是,一般來說,網絡蜘蛛都會遵守這個協議的。其實,我們除了通過Robots.txt來拒接網絡蜘蛛的爬行之外,我們還可以通過其他方法來拒接網絡蜘蛛的爬行的。

網絡蜘蛛在下載網頁的時候,會去識別網頁的HTML代碼,在其代碼的部分,會有META標識。通過這些標識,可以告訴網絡蜘蛛本網頁是否需要被抓取,還可以告訴網絡蜘蛛本網頁中的鏈接是否需要被繼續跟蹤。例如: 表示本網頁不需要被抓取,但是網頁內的鏈接需要被跟蹤。

一般的網站都希望搜索引擎能更全面的抓取自己網站的網頁,因為這樣可以讓更多的訪問者能通過搜索引擎找到此網站。為了讓本網站的網頁更全面被抓取到,網站管理員可以建立一個網站地圖,即Site Map。許多網絡蜘蛛會把sitemap.htm文件作為一個網站網頁爬取的入口,網站管理員可以把網站內部所有網頁的鏈接放在這個文件里面,那么網絡蜘蛛可以很方便的把整個網站抓取下來,避免遺漏某些網頁,也會減小對網站服務器的負擔。

二、網站權重

在了解了網絡蜘蛛的基本原理之外,接下來,我們就一起去了解一下,網站權重的基本知識吧。

網站權重,一般是指:搜索引擎對網站進行評估評價后,給網站賦予的一定的權威值。一個網站的權重越高,那么這個網站在搜索引擎中所占的分量也就越大,關鍵詞排名也就越好。雖然說,基本每一個SEOER都會討論和研究網站權重。但是,在某些搜索引擎中,這個標準是不存在的。概括的說:就是網站與網站在搜索引擎眼中的分級制“待遇”的不同表現。誤區:例如人們經常討論的百度權重其實并不是百度官方給出的概念,而是一些第三方站長網站推出的針對網站關鍵詞排名預計給網站帶來流量,劃分等級0-10第三方網站歡迎度評估數據。影響網站權重的因素較多,主要有以下幾種:

網站架構

網站結構不盡需要迎合搜索引擎的喜好,更要符合用戶體驗的要求。而優質的網站架構一般為扁平式,既:主頁>欄目頁>內容頁,同時站點還應包含TAG標簽,留言評論、文章搜索等。

域名類型

一般來說,gov和edu類型的域名的權重會比較高一點。因為,用這一類域名的站點基本為政府高校的網站,很少是草根個人的小站。其實,com、net、org的域名權重相對較高,一些有國家和地區特點的域名后綴建議不要選。從用戶習慣來看,com已成為首選。最后域名的注冊年齡越久,搜索引擎給予的信任越高。

導入鏈接

雖然外鏈的時代已經過去了。但是,外鏈對于網站來說,還是很重要的。只是在今時今日,我們不僅需要做好外鏈的數量,更需要做好外鏈的質量。只有優質的外鏈,才能幫助到網站。如果一昧的提高外鏈的數量,則是很容易受到搜索引擎的懲罰的。

網站內容

“外鏈為皇,內容為王”這句話充分的表達出了,內容對于網站權重的重要性。如果能長時間為網站創造出優質的原創內容的話,網站權重自然會蹭蹭往上加的。因為,原創內容就是為搜索引擎注入新鮮的血液。如果,實在原創不出什么內容的時候,那就偽原創一下。。切忌原封不動的復制粘貼,尤其是機器采集后進行所謂的自動偽原創,更有甚者前后兩段抄堆疊關鍵詞或者所謂的偽原創,其實段落語句不通,用戶體驗差,網站跳出率高,同樣也不會有好的權重。

收錄數量

堅持更新站點,合理布置鏈接誘餌,增加站點頁面的收錄數量。雖說收錄數量與權重之間不是絕對關系,但你見過同類型同行業的網站收錄數量僅有幾十的權重高于幾萬的情況嗎?

關鍵詞排名

尤其是核心關鍵詞的排名。首先要明白搜索引擎為什么會給你的關鍵詞一個較高的排名,因為權重高了。其次,認真做好相關關鍵詞和長尾關鍵詞的排名,這有利于提升網站的整體權重。

更新頻率

堅持有規律的更新網站,除了會獲得及時的網頁快照外,還能增加搜索引擎的信任度,一個更新頻繁的網站比那些僵尸網站的權重肯定會高很多。同時,應注意更新時間和更新數量,避免之前積累的權重慢慢流失了。

內容頁

內頁是否和首頁以及網站主題有較為緊密的聯系,內頁之間的銜接、關鍵字的布局,以及內頁是否具有專業性,權威度如何。

網站的誠信度

Google除PR值以外,還有一個誠信指數。即通過對一些高質量網站的分析,給出一個“誠信”網站應該有的一些指標,并用這些指標來分析一個網站的誠信度。

網站服務器

服務器穩定是關鍵,如果說搜索引擎抓取頁面時網站空間無法訪問,特別是新站,網站服務器不穩定可能導致搜索引擎不收錄網站。其次是網站頁面的打開速度,這些服務器因素對權重都有影響。

最后聲明下,權重跟排名不能劃為等號;就像PR≠排名,當然這只是SEO細節中的一個重要組成部分。權重的高低是影響關鍵詞排名其中的一項重要因素而已。

三、路徑原理及影響

說完了網絡蜘蛛和網站權重的基本原理之后,下面我們就用這些原理來闡述一下,域名路徑的長短是否會影響到SEO優化的效果呢?

首先,我們先去了解一下靜態路徑的規則:

靜態路徑的規則為:域名/靜態總目錄/語言目錄/主分類/子分類/內容名.html,其實靜態總目錄是可以去掉或者修改的。如果為單語言的情況下面,語言目錄也是可以去掉的,但如果為多語言,則此目錄必須保留,以避免相同語言相同目錄及內容的覆蓋。

在上面介紹中,我們說過網絡蜘蛛抓取,是根據頁面訪問層級來進行抓取的,而不是目錄層級,如下圖所示:

假如現在內容J中有URL為:http://www.pzdsw.cn/news/xingyeba/10519.html,如果此內容的鏈接出現在J和出現在A層,那么可以分別理解為0層和3層,這種意義是不一樣。如果出現在A層中,那么網絡蜘蛛在第一次抓取中就比較容易尋獲取此URL,并進行抓取保存,而如果出現在J層中,那么當網絡蜘蛛只設定了二層后,就抓取不到了。這種層級關系的理解,不是域名文件夾的層級關系,而是瀏覽深度指向的層級。

所以說,網站后臺生成的靜態URL文件夾的多與少,其實對SEO優化效果來說,基本是沒有影響的。但是,如果你的網站是英文網站的會啊,那么請注意了文件夾的生成文件名,是有一定的影響的。比如產品文件夾的名稱設定成products和設定成cb,那是有很大的關系的,所以切記一條:文件夾盡量取英文名或者英文代表關鍵字。

那有人又會說了:既然您網絡蜘蛛沒有影響,那權重呢?總會有一定的影響吧?先前說過了,網頁權重影響主要是內容質量、關鍵字、域名、點擊數量、收錄數量、服務器速度等因素,URL的長短實際很少,如果不信,您要中以搜索一下百度或者谷歌,他們收錄中,同樣有非常長的URL網頁。

談了這么多原理性之后,不知您還是否跟其它SEOER一樣,同樣認為URL長度影響質量呢?如果您還堅持您的觀點,可以多了解一下搜索技術方面的文章,而不是SEO營銷方面的文章,SEOER更不該誤人子弟,正確理解SEO的重要性,還是對您網站內容的質量、內鏈著手吧!